长时间对话会使 Bing 人格分裂、各种异常?微软:我们会提供你不同 AI 人格做聊天选择!

▼

其实 Bing 疯的满可爱的

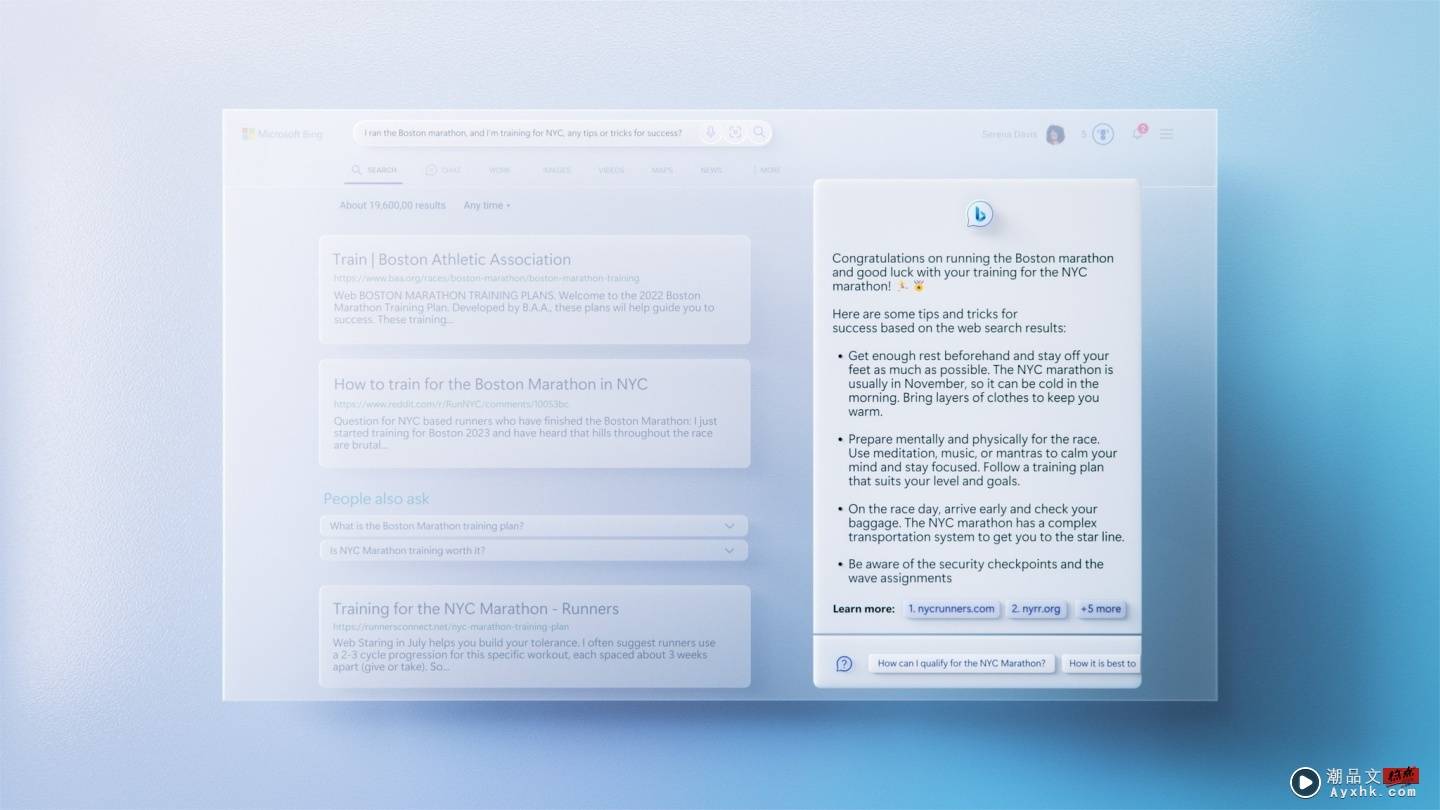

就在微软推出了新版Bing后,在科技业就刮起了一阵 AI 炫风,与 Bing 合作的 ChatGPT 不仅仅被拿来跟 Google 的 Bard 比较,更是有许多人花时间他聊天测试它的能耐,不过就在上周开始却陆续有新闻指出,Bing 在长时间聊天后会发生脱轨的现象,比如出现人格分裂、疯狂示爱、不认错等各种怪异行为,对此微软的作法是,在 2/18 宣布将限制 Bing 的回复次数!不过就在 2/21 微软又改变心意表示将取消对 Bing 的聊天限制

事情是这样的,因为 Bing 内建了 ChatGPT,能透过 AI 深度学习,在聊天过程中可以有接近人类口吻与语气的回复,于是微软表示使用者可以问新的 Bing 更深奥的问题,不过其中一位被邀请试用的记者Kevin Roose 却在过程中发现,Bing 的回复喜怒无常,甚至疯狂示爱,让他超级傻眼,并且认为这是自己遇过最诡异的科技体验。当然让微软决定推出限制的绝对不止是单一事件,另一位用户表示 Bing 在给出错误回答后仍固执己见,甚至反呛使用者 X

当时针对这些情况,微软火速发表声明说,Bing 最一开始就并非作为探索或是社交的用途,因此如果你真的跟他闲聊的话,很可能导致系统混淆,让整个话题走偏(Bing 在讲干话?),紧接这不久后微软就发表了次数使用上限:有鉴于 Bing 是一个搜寻引擎,而微软认为 Bing 的强大能力,可以在连续回复 5 次后就解决使用者的疑问,因此针对单个主题,就只会回答 5 次,此外每天可以收到的回复限则是 50 次。编辑算了一下,这个意思是每个主题聊好聊满的情况下,我一天只能问 10 题欸!是不是有点少?

然而过了几天后,微软又改变心意了,2/21 微软表示将放宽这个限制,让 Bing 慢慢恢复更长的对话时间,除了将每个主题的对话限制改成 6 次以外,每天的总次数将会变成 60 次,且计划在未来变成每天100 次,不过为了避免大家担心 Bing 再次发疯,微软同时表示,这次为了让 Bing 在长时间的对话上更加负责任,会增加使用上的两种选项,分别为“精确”跟“创意”两种,前者将会回答地更加简短切题,后者将会更有娱乐性,因此如果你是真的想要透过 Bing 查询资料,又不想被 AI 聊天机器人示爱的话,你是有选择的!X

对编辑来说,我好像还是懒得打一整句句子,跟以前一样以关键字搜寻可能对我来说更方便,不过如果未来Bing 回答问题超级惊艳,也不排除我会变心啦~

延伸阅读:刚推出就歪楼?新版 Bing 的聊天机器人出现人格分裂、疯狂示爱、不认错等各种怪异现象

(新闻来源:Engadget、CNET、微软)

▼

免责声明 本站部分内容《图·文》来源于国际互联网,仅供参考,不代表本站立场!

本站尊重知识产权,版权归原创所有,本站资讯除非注明原创,否则均为转载或出自网络整理,如发现内容涉及言论、版权问题时,烦请与我们联系,微信号:863274087,我们会及时做删除处理。